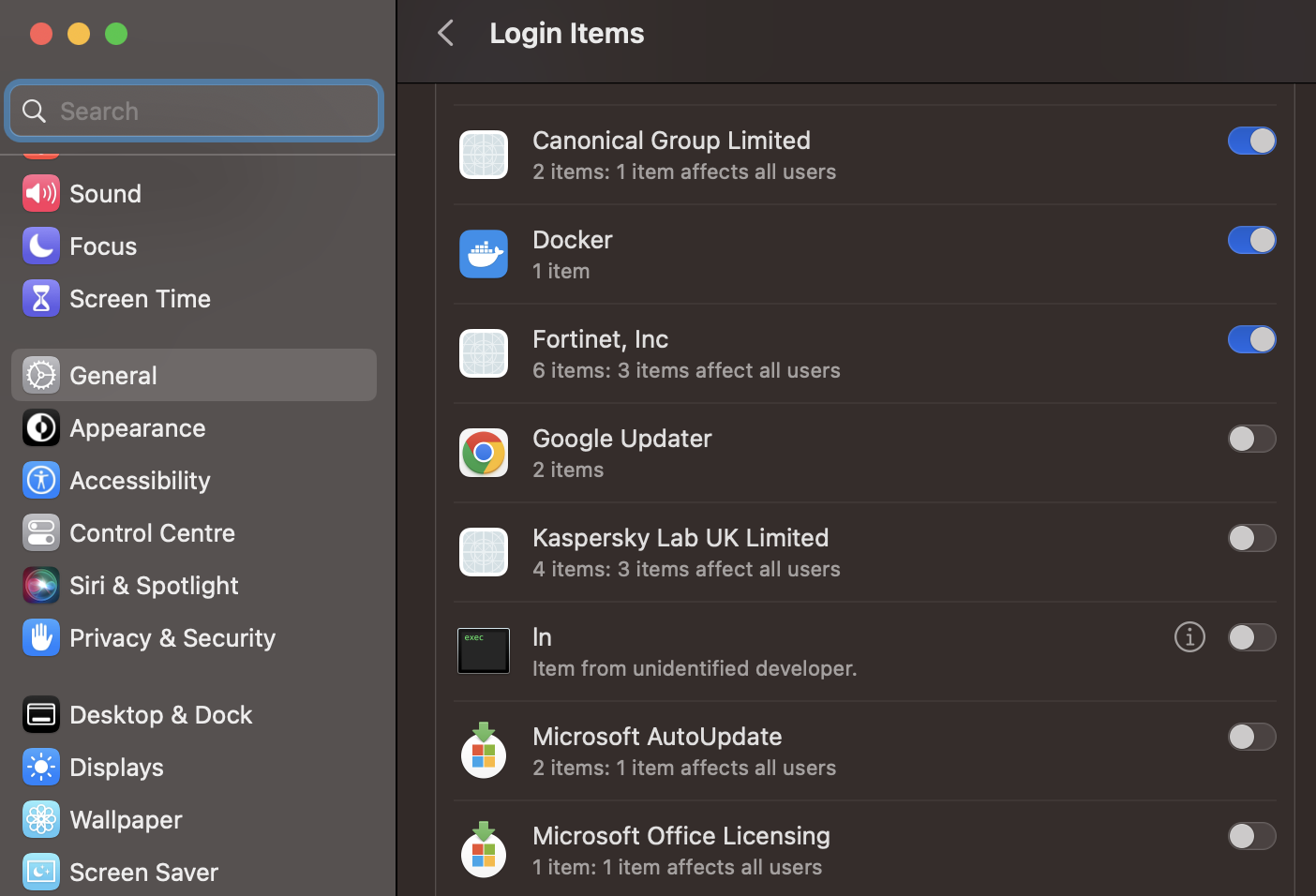

Пробегал мимо настроек, решил на всякий случай заглянуть в то, что у меня пускается автоматом. Settings-General-Login Items, а там такое

Что за ln? При нажатии на значок информации честно перекидывает на /bin/ln. Троян?

$ codesign -dvvv /bin/ln

Executable=/bin/ln

Identifier=com.apple.ln

Format=Mach-O universal (x86_64 arm64e)

CodeDirectory v=20400 size=453 flags=0x0(none) hashes=9+2 location=embedded

Platform identifier=14

Hash type=sha256 size=32

CandidateCDHash sha256=da717c2e8dc49817f70f208029b3533b4c9cdb2c

CandidateCDHashFull sha256=da717c2e8dc49817f70f208029b3533b4c9cdb2ceacfa90a43b19009331880fb

Hash choices=sha256

CMSDigest=da717c2e8dc49817f70f208029b3533b4c9cdb2ceacfa90a43b19009331880fb

CMSDigestType=2

Launch Constraints:

None

CDHash=da717c2e8dc49817f70f208029b3533b4c9cdb2c

Signature size=4442

Authority=Software Signing

Authority=Apple Code Signing Certification Authority

Authority=Apple Root CA

Signed Time=5 Nov 2022, 04:23:08

Info.plist=not bound

TeamIdentifier=not set

Sealed Resources=none

Internal requirements count=1 size=60

Нет, не троян. Уже лучше. Значит ищем в {~}/Library/LaunchAgents то, что под это маскируется. Оказывается, это Docker Desktop такой херней развлекается

$ cat com.docker.socket.plist

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE plist PUBLIC "-//Apple//DTD PLIST 1.0//EN" "http://www.apple.com/DTDs/PropertyList-1.0.dtd">

<plist version="1.0"><dict><key>KeepAlive</key><false/><key>Label</key><string>com.docker.socket</string><key>ProcessType</key><string>Background</string><key>Program</key><string>/bin/ln</string><key>ProgramArguments</key><array><string>/bin/ln</string><string>-s</string><string>-f</string><string>/Users/kiltum/.docker/run/docker.sock</string><string>/var/run/docker.sock</string></array><key>RunAtLoad</key><true/></dict></plist>Что делать? Да ничего. При запуске Docker Desktop он просто сругается и предложит сделать эту ссылку заново. Ну или оставьте “сервис ln” включенным