Следующим большим шагом в постройке “датацентра” у меня будет разворачивание докера. Без него нынче никуда, да и удобный он, зараза.

Согласно всем мануалам для новичков, для минимально живучего кластера необходимо заиметь три машины. А у меня одна, но зато физическая. Значит, поднимаю три виртуалки и туда запихиваю докер.

Но три виртуалки – это уже не одна. Требуется автоматизация. Вариантов много – от правки кикстарт файлов до клонирования уже существующих машин. Но тут я решил пойти другим путем, более простым в случае использования KVM

Добываю/делаю правильный ifcfg фаил

cat ifcfg-eth0

TYPE="Ethernet"

DEFROUTE="yes"

IPV4_FAILURE_FATAL="no"

IPV6INIT="no"

NAME="eth0"

DEVICE="eth0"

ONBOOT="yes"

IPADDR="172.16.100.11"

PREFIX="24"

GATEWAY="172.16.100.1"

NM_CONTROLLED="no"

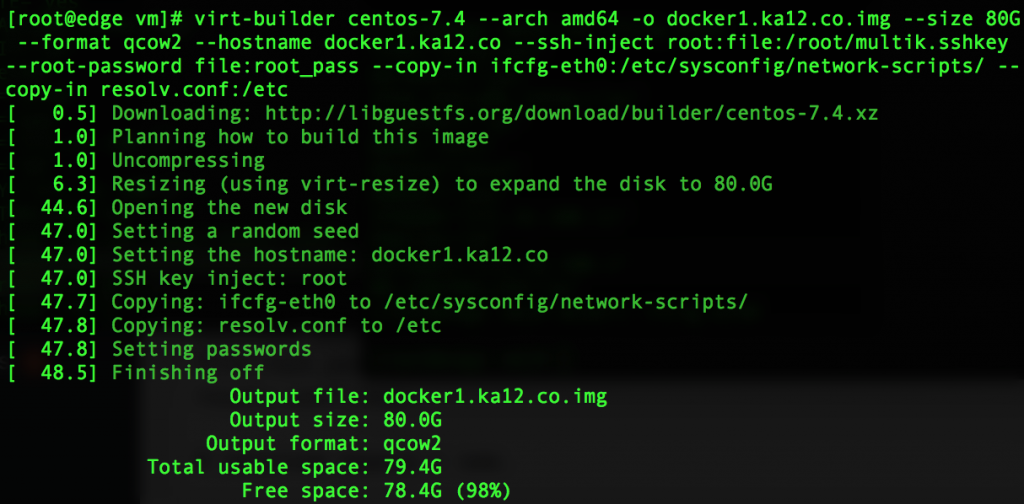

Добавляю пароль рута в файл root_pass и кладу рядом свой публичный ключ. Рядом же resolv.conf. Затем создаю образ диска

virt-builder centos-7.4 --arch amd64 -o docker1.ka12.co.img --size 80G --format qcow2 --hostname docker1.ka12.co --ssh-inject root:file:/root/multik.sshkey --root-password file:root_pass --copy-in ifcfg-eth0:/etc/sysconfig/network-scripts/ --copy-in resolv.conf:/etc

И запускаю машину с ним.

virt-install --name docker1.ka12.co --network bridge=virbr100 --memory 8096 --disk path=docker1.ka12.co.img --import --os-variant centos7.0 --graphics vnc,listen=172.16.100.1 --noautoconsole

Минута и виртуалка готова. Меняем ip адрес в конфиге+хостнейм и повторяем так еще два раза. Все, ноды для кластера готовы.

Добавляем их в инвентори и бутсрапим до приемлемого состояния.

ansible-playbook -i inventory -l docker* centos-bootstrap.yml

Делать еще один плейбук лень, поэтому просто прохожу по хостам с командой

yum -y install freeipa-client && ipa-client-install --mkhomedir

ansible-playbook -i inventory docker-install.yml

И на любой машине проверяю, что докер докерит

docker run hello-world

Так как у нас инфраструктура пока из одного хоста, заморачиваться распределенным хранилищем нет смысла от слова совсем. Поэтому просто раскидаю по хостам nfs

На хосте:

mkdir -p /opt/nfs

chmod 777 /opt/nfs

cat /etc/exports

/opt/nfs 172.16.0.0/16(rw,sync,no_root_squash,no_all_squash)

systemctl restart nfs-server

Проверяю, что увидит докер

# showmount -e 172.16.100.1

Export list for 172.16.100.1:

/opt/nfs 172.16.0.0/16

Создаю супер-каталог для volume

mkdir -p /opt/nfs/data

chmod 777 /opt/nfs/data

Теперь на докер-хосте создаю volume

docker volume create --driver local --opt type=nfs --opt o=addr=172.16.100.1,rw --opt device=:/opt/nfs/data --name data

И проверяю

[root@docker1 ~]# docker volume ls

DRIVER VOLUME NAME

local data

[root@docker1 ~]# docker volume inspect data

[

{

"CreatedAt": "2018-01-27T08:46:56-05:00",

"Driver": "local",

"Labels": {},

"Mountpoint": "/var/lib/docker/volumes/data/_data",

"Name": "data",

"Options": {

"device": ":/opt/nfs/data",

"o": "addr=172.16.100.1,rw",

"type": "nfs"

},

"Scope": "local"

}

]

Теперь проверяю, как с этим будут работать контейнеры

docker container run -ti -v data:/data alpine sh

Там в /data можно посоздавать файлики и вообще поиграться “как будто в реальной жизни”.